KOMPAS.com – Tim riset perusahaan teknologi Apple mengklaim telah menemukan kelemahan pada kecerdasan buatan (AI).

Read More : Ponsel Fitur Nokia 110 4G dan 105 4G Versi Baru Dirilis, Kini Pakai USB-C

Sebuah studi yang dipimpin oleh insinyur penelitian pembelajaran mesin (ML) Iman Mirzadeh menunjukkan bahwa perubahan kecil pada urutan soal matematika dalam model bahasa skala besar (LLM) dapat membuat perbedaan besar dalam performa model yang saya temukan.

Akurasi respons LLM sekitar 65% lebih rendah, sehingga kurang dapat diandalkan dalam situasi yang memerlukan logika konsisten.

FYI, LLM bukan sekedar bahasa pengolah, melainkan program atau model yang mengenali dan menghasilkan teks. Ini memungkinkan Anda berinteraksi dengan pengguna menggunakan bahasa alami.

Model bahasa besar dilatih menggunakan kumpulan data yang sangat besar. Oleh karena itu, LLM disebut model bahasa skala besar.

LLM ini mendukung program AI generatif seperti ChatGPT dan Microsoft Copilot (AI/AI generatif yang dapat menghasilkan teks, video, dan audio).

Baca Juga: Prediksi Sam Chatgpt Altman untuk Masa Depan AI

Pertanyaan tentang buah kiwi

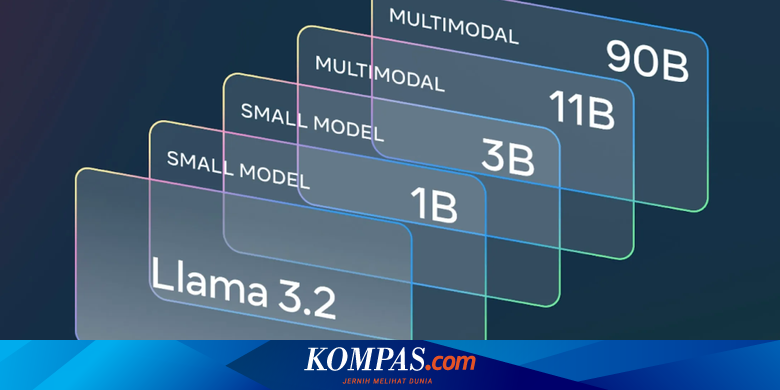

Studi tim peneliti Apple menguji berbagai model bahasa berskala besar terkemuka, termasuk OpenAI dan Meta, untuk melihat bagaimana mereka dapat menangani tugas penalaran matematika.

Sampel bahasa yang besar diuji menggunakan alat pengujian baru (benchmark) yang disebut GSM-Symbolic.

Read More : Rusia Denda Google 2,5 Desiliun Dollar AS gara-gara Tolak Permintaan Ini

Para peneliti telah menunjukkan dalam beberapa tes bahwa menambahkan informasi yang tidak relevan ke pertanyaan matematika dapat menghasilkan jawaban berbeda dalam sampel bahasa yang besar.

Padahal, rincian tersebut seharusnya tidak mempengaruhi hasil perhitungan matematis yang dilakukan oleh LLM.

Misalnya, peneliti mengajukan pertanyaan matematika sederhana tentang berapa banyak telinga yang dikumpulkan seseorang dalam beberapa hari.

Ketika peneliti memasukkan informasi seperti ukuran buah kiwi, model LLM seperti OpenAI o1 dan Meta’s Llama salah menghitung jumlah total buah kiwi.

Akurasi lebih rendah untuk model LLM open source dan berlisensi.

Baca Juga: OpenAI rilis o1, AI yang bisa berpikir seperti manusia

Peneliti menyimpulkan kelemahan inferensi ini adalah LLM tidak menggunakan logika sebenarnya untuk menyelesaikan masalah, melainkan mengandalkan pengenalan pola tingkat lanjut yang dipelajari selama pelatihan.